六十四卦之火雷噬嗑

火雷噬嗑

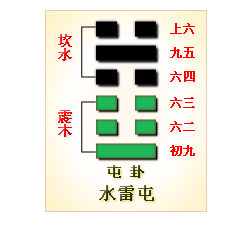

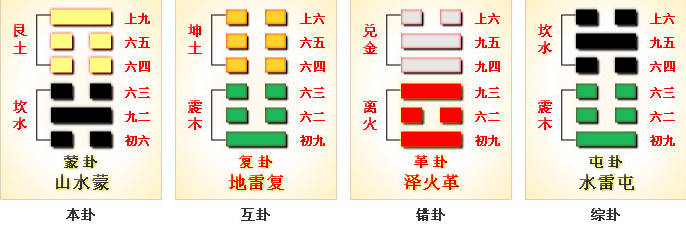

噬嗑,上(外)离(火、明、丽、电)下(内)震(雷、动、刑法),动而明、威猛而光明。雷(震)电(离、光明)合章。以雷霆之势(法)行光明之事(公正判断),象征 以明正之道破除阻隔、辨明是非、惩恶扬善、明正刑法,是以法明德的卦。

噬嗑,亨。利用狱。 |

彖曰:颐中有物,曰噬嗑,噬嗑而亨。刚柔分,动而明,雷电合而章。柔得中而上行,虽不当位,利用狱也。 |

象曰:雷电噬嗑;先王以明罚敕法。 |

- 噬嗑 : 噬,咬、噬食;嗑,合口、上下颚咬合。象征着咬合、咀嚼,引申为解决问题、清除障碍、治理乱象。

- 利用狱 : 狱,古代指 刑罚、司法审判。以公正的刑罚治理乱象。

- 颐中有物 : 颐,口、口腔、脸颊。口中有物不能合,必须咬断它才能通。象征社会中有障碍或邪恶之物,需以明正之法除去。

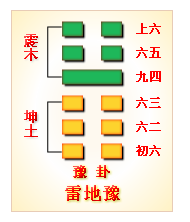

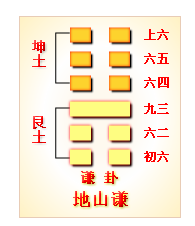

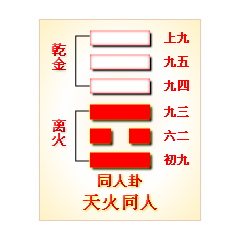

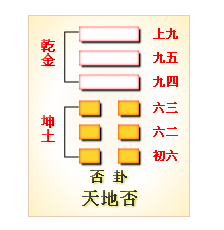

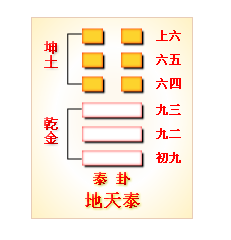

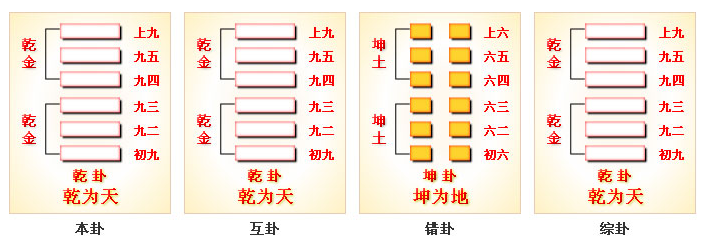

- 柔得中而上行 : 噬嗑卦由否卦(天地否)变化而来,否卦初六柔爻上行至六五成为火雷噬嗑卦,否卦天上地下,阴阳阻隔,上下不通,变为噬嗑卦,柔得中上行,刚柔分,亨。六五为卦主。

- 雷电合而章 : 章,彰显、有效。雷者威,电者明。雷与电相合,象征威与明并施,刑法分明。

- 先王以明罚敕法 : 敕法,制定和执行法律。

古人注解 :

颐中有物,喻天下有奸邪。雷动火明,以威明并施,去害而通,故曰噬嗑亨。王弼

噬嗑者,去害通塞也。动以行之,明以照之,刚柔相济,故亨。程颐

噬嗑,断也。治天下之道,贵在明察与决断。明而不决,则奸萌;决而不明,则刑滥。朱熹

噬嗑,以刚明决物也。雷火相济,威明并施,刑法所以立也。

初九

屦校灭趾,无咎。 |

象曰:屦校灭趾,不行也。 |

- 屦(jù)校(jiào)灭趾 : 屦,本义位鞋、鞋子,寅申为穿戴、套上。校,木板制成的刑具,古代特指脚镣,有别于枷(束缚颈部)和桎梏(手脚均束缚),属于较轻的刑具。灭,没也,指覆盖、遮住。刑具大小只是遮盖了脚趾,象征着受到轻微的惩罚或约束。比喻早制其恶,微罚以止

初九阳爻居阳位,得位,处噬嗑卦最下位,即使犯错,尚在萌芽阶段,属于防微杜渐之时。早制其恶,小惩大诫。防微杜渐,是明法之道。

古人注解 :

屦校灭趾者,微罚以禁非也。止恶于初,虽痛无咎。王弼

恶之始生,轻刑足以止之。灭趾而止,不行也。程颐

法施于初,轻而有制。止恶于萌,故无咎。朱熹

屦校灭趾,小刑也。止其过而不使行,故无咎。

六二

噬肤灭鼻,无咎。 |

象曰:噬肤灭鼻,乘刚也。 |

- 噬肤灭鼻 : 肤,带皮得肉,软肉、鲜肉,比较肥美。 灭鼻,鼻子没入。

古人注解 :

王弼

噬肤灭鼻者,刑之轻也。虽伤颜面,而能止恶,故无咎。程颐

噬肤,浅也;灭鼻,伤表也。以柔中而受制于刚,正其不正,虽伤无咎。朱熹

噬肤灭鼻,轻刑也。居中而顺,受上所制,虽伤犹吉。

六三

噬腊肉,遇毒。小吝,无咎。 |

象曰:遇毒,位不当也。 |

- 噬腊肉,遇毒 : 腊肉,腌制或熏制的肉,比较坚硬。毒,毒害、危害。象征着处理问题时遇到的阻力较大,处理问题时遇到了阻碍、困难或危害。

六三爻是阴爻居阳位,位置不正不中,刚柔交际之处。象征着行为或决策可能不够恰当,柔居刚位,可能缺乏刚健的行动力。

古人注解 :

王弼

腊肉坚也。噬之艰也。遇毒者,邪害之象。位不中正,故虽行法而多险。程颐

三以阴居阳,任非其分,虽欲行法以正恶,而多险阻,能守正故无咎。朱熹

噬腊肉,事坚而难。遇毒,以不中正也。然守正不失,故小吝无咎。

九四

噬乾胏,得金矢,利艰贞,吉。 |

象曰:利艰贞吉,未光也。 |

- 噬乾胏,得金矢 : 乾,干枯、干燥。胏,胸腔肉、带骨得肉。矢,箭。得金矢,象征着在处理坚实难断的问题时得到了有力的支持或工具。

- 利艰贞吉,未光也 : 虽然取得了吉祥的结果,但还没有达到完全的圆满。这里的未光暗示了虽然成功,但仍有提升的空间。离为光明,九四处离最下爻,和六五相比,算是未光。

古人注解 :

王弼

噬乾胏,坚物也;得金矢,刚正也。艰贞乃吉,行法得中。未光,谓德虽正而未昭也。程颐

四以阳居阴,刚中而能下,得行其正。虽艰难而终吉,然未至大明,故曰未光。朱熹

噬乾胏,言所治坚难;得金矢,刚正之象;未光,谓功业未极也。

六五

噬乾肉,得黄金,贞厉,无咎。 |

象曰:贞厉无咎,得当也。 |

- 噬乾肉,得黄金 : 黄,中央之色,喻中(六五爻居中)。君主凭借权威、中正,为解决全局得重大问题(噬乾肉)提供保障。

古人注解 :

王弼

乾肉坚实,重罪之象。得黄金者,得刚中之德。处尊守中,虽危而无咎。程颐

五以柔中居尊位,得应于刚中之二,刚柔得宜,行刑得正。虽危而无咎。朱熹

噬乾肉,言事之坚实。得黄金,刚中之象。贞厉无咎,守正而慎刑也。

上九

何校灭耳,凶。 |

象曰:何校灭耳,聪不明也。 |

- 何校灭耳 : 何,通荷,背负、戴上、承担。灭耳,指刑具遮盖了耳朵,象征着受到的惩罚非常严重。上互卦坎为耳,上卦离为目。上九在坎上,故灭耳。

- 聪不明也 : 聪,听觉灵敏、听力。明,视力好、明察、明智。聪不明也,指耳不聪、目不明。

阳爻居上位,刚极而不中,象征刚暴过盛。处卦之终,行刑已极,过度使用威力。

古人注解 :

灭耳者,刑过也。治之以刚,失其中和,故凶。王弼

法施太过,听不及下,刑及无罪,是以凶也。程颐

噬嗑之道,以明断为贵;刚极则暴,不复听谏,故凶。朱熹

何校灭耳,刑过失中之象。聪不明,谓刚暴不纳谏也。